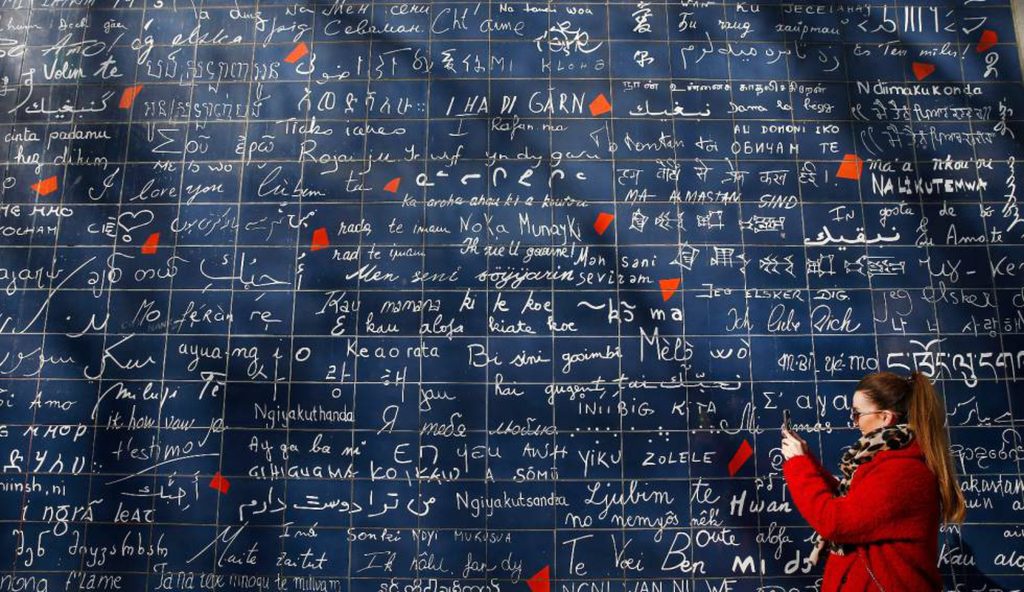

Hablar distintos idiomas puede ser una barrera insalvable para la comunicación. Los directivos de Meta están decididos a facilitar todo lo posible las conexiones entre personas de distintos países y/o culturas. Tanto para que aumenten las interacciones en las redes sociales de la compañía como para que en un futuro haga más atractivo el metaverso. Los investigadores de Meta llevan años trabajando en sofisticados modelos de inteligencia artificial (IA) capaces de traducir varias lenguas. Hoy han presentado NLLB-200, un sistema pionero capaz de traducir en tiempo real 200 idiomas, el doble de que las que computaban en el mejor sistema que tenía Meta hasta ahora.

“Las técnicas de modelaje de IA que hemos usado están ayudando a obtener traducciones de gran calidad”, subraya el fundador y CEO de Meta, Mark Zuckerberg, en un post colgado hoy en su cuenta de Facebook. “Para dar una idea de la escala del programa, el modelo de 200 idiomas analiza más de 50.000 millones de parámetros. Lo hemos entrenado usando el Research SuperCluster, uno de los superordenadores más rápidos del mundo”. El sistema NLLB-200, acrónimo de No Language Left Behind (Ningún idioma se queda atrás), está preparado para realizar 25.000 traducciones diarias en todas las apps de Meta, según destaca el joven magnate.

La intención de la compañía es que en un futuro las gafas de realidad aumentada de Meta sean capaces de traducir en tiempo real y servir subtítulos visibles solo para quien lleva las lentes. Google también trabaja en esa línea, tal y como reveló en mayo cuando presentó un prototipo similar de gafas.

Código abierto

El modelo en el que se basa NLLB-200 bebe de M2M-100, presentado en 2020 y que presentó una mejora fundamental: las traducciones se hacen directamente del idioma de origen al de destino, sin pasar por el inglés. Al ser este último el más común en internet, es también el que alimenta la mayoría de bases de datos del mundo con las que se entrenan los sistemas de procesamiento del lenguaje natural. De ahí que los traductores pasasen cualquier idioma antes al inglés para luego traducirlo a otro, lo que origina una gran pérdida de matices y significado.

Para conseguir dar ese salto hacen falta millones de oraciones emparejadas meticulosamente entre distintas combinaciones de idiomas. El problema es que hay lenguajes infrarrepresentados en internet. Meta da el ejemplo del sueco y el lingala, una lengua hablada en la República Democrática del Congo, la República del Congo, la República Centroafricana y en Sudán del Sur. El idioma europeo, usado por 10 millones de suecos y finlandeses, tiene unos 2,5 millones de artículos en Wikipedia; el africano, practicado por 45 millones de personas, solo cuenta con 3.260.

Para solventar ese problema, los investigadores de Meta han perfeccionado un modelo capaz de extraer un gran rendimiento de cada oración analizada, a la vez que han aumentado el tamaño de las bases de datos que nutren el algoritmo.

La compañía ha decidido publicar en código abierto el modelo de NLLB-200 y su código de entrenamiento del modelo con el objetivo de ayudar a otros investigadores a mejorar sus herramientas de traducción y desarrollar nuevas tecnologías.

Fuente: El Pais, España.